本文介绍在mac笔记本电脑上本地部署deepseek模型

基于Ollama+OpenUI

安装Ollama

快速安装:

访问Ollama官方网站:https://ollama.com,点击“download”下载对应操作系统的安装包,并按照提示进行安装。

官网还提供了一条命令行快速安装的方法用于安装Linux版本,即运行以下命令:

curl -fsSL https://ollama.com/install.sh | sh。此命令将自动下载最新版本的Ollama并完成安装。

手动安装:

下载二进制文件:将Ollama的二进制文件下载到PATH中的目录。例如,对于Linux系统,可以使用以下命令:

sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollamasudo chmod +x /usr/bin/ollama添加为自启动服务(可选):可以创建Ollama服务文件,并将其设置为自启动。具体步骤包括创建Ollama用户、编辑服务文件、重载systemd配置、启用并启动Ollama服务等。

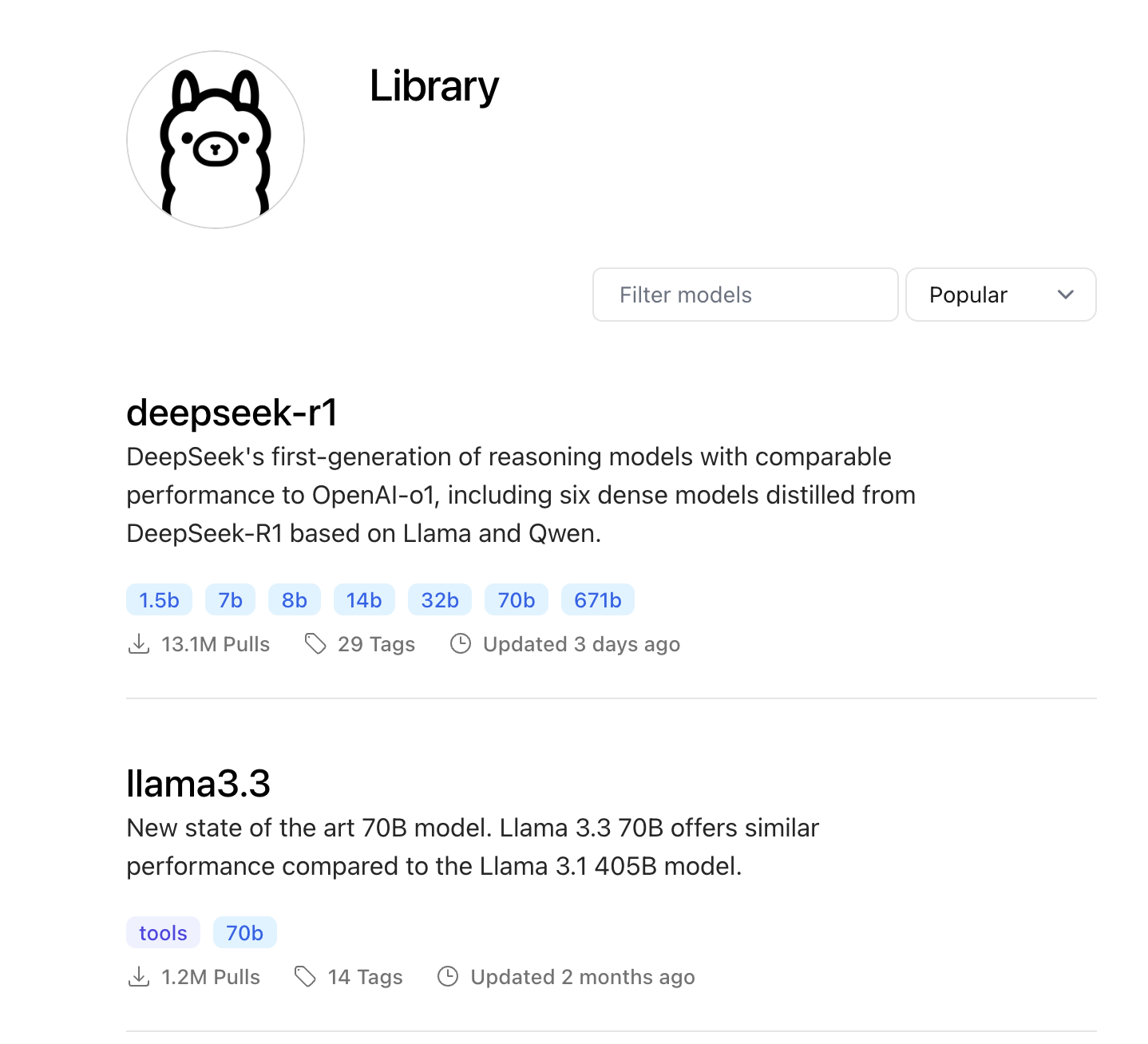

Ollama的模型安装

从Ollama模型库下载:

启动Ollama后,访问其模型库(如https://ollama.com/library),搜索并下载所需的模型。

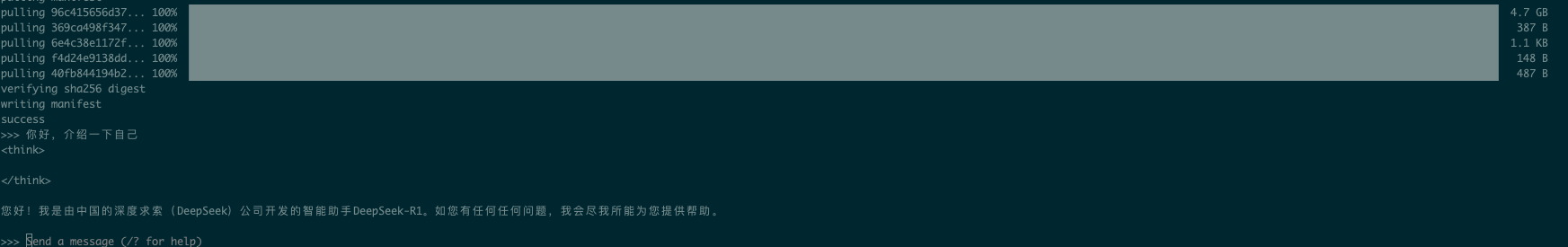

比如我安装了基于千文蒸馏的7b模型:

ollama run deepseek-r1:7b

从HuggingFace下载并导入:

访问HuggingFace网站,搜索并下载所需的模型文件(如LLaMa3的中文模型)。如果HuggingFace访问不了,可以使用国内替代网站:https://opencsg.com/models

下载完成后,需要编写一个配置文件来指定模型文件的位置和模板等。

使用

ollama create命令根据配置文件创建模型。例如:ollama create llama3-cn-8b ./ollama_Llama3_config.txt

此时就可以使用deepseek r1模型进行对话了

但是这种命令行式的对话很不方便,我们需要一个web页面在浏览器中进行对话,还可以与他人分享你的chat服务。接下来我们就需要一个webUI来提供这种能力。

安装Open webUI

通过Docker快速部署

# 拉取镜像并启动 docker run -d --name open-webui \ -p 3000:8080 \ -e OLLAMA_BASE_URL=http://host.docker.internal:11434 \ -v open-webui:/app/backend/data \ --add-host=host.docker.internal:host-gateway \ ghcr.io/open-webui/open-webui:main 或者安装python版本 pip install open-webui open-webui serve --port 3000验证服务

浏览器访问

http://localhost:3000注册账号并登录

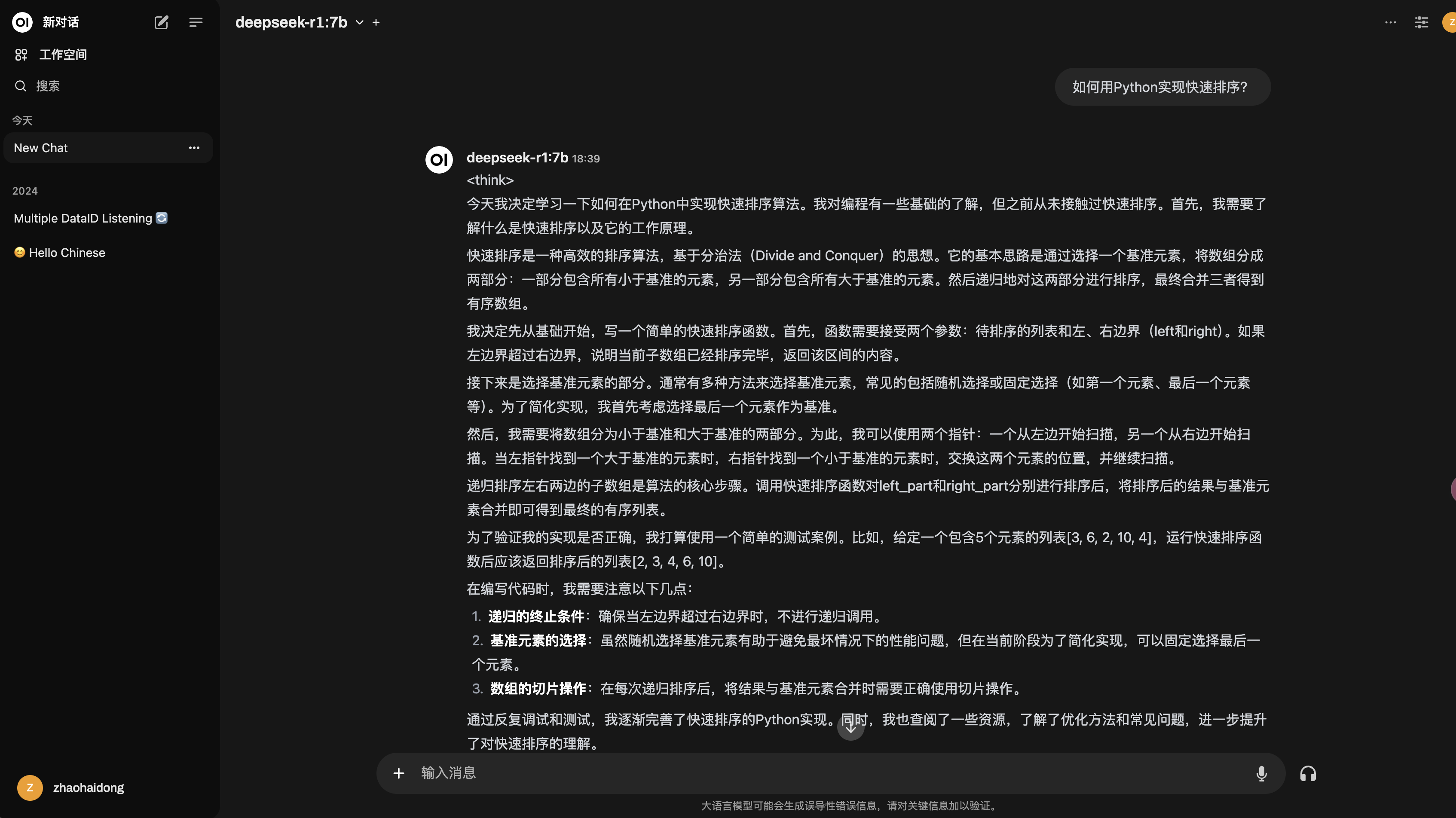

连接Ollama模型

进入设置界面 → 选择已安装的

deepseek-7b模型调整参数(temperature, max tokens等)

对话测试

评论区